Nel corso di una nuova sessione in diretta streaming, Ilario Gobbi ha ospitato nuovamente Francesco Margherita, consulente SEO con esperienza dal 2007 e fondatore della community “Fatti di SEO”, per un confronto serrato sulle trasformazioni della SEO nell’era dell’intelligenza artificiale generativa. L’incontro, articolato e denso di riflessioni, ha attraversato i punti focali che oggi impongono una ridefinizione delle strategie di ottimizzazione per i motori di ricerca, a partire dalla riformulazione della SEO audit fino alle nuove modalità di tracciamento e posizionamento nei contesti digitali emergenti.

Ridefinire la SEO audit in risposta all’intelligenza artificiale generativa

Secondo Margherita, l’impatto delle nuove interfacce AI — come l’AI Overview e AI Mode di Google — impone una netta biforcazione nell’approccio alla SEO audit, suddividendola in due tronconi: l’audit tecnico-strutturale e quella che definisce audit editoriale-strategica.

L’analisi tecnica resta centrale e si sviluppa secondo un modello consolidato ma integrato: analisi dei dati strutturati e delle entità, copertura indice tramite Google Search Console, statistiche di scansione con supporto eventuale di log analysis, Screaming Frog per la SEO checklist, confronto tra pagine visibili e indicizzate, verifica dell’intervento di Googlebot e analisi del comportamento reale degli utenti. A queste si aggiunge un approfondimento dell’architettura informativa del sito a partire dalla sitemap, esaminando la struttura interna in ottica di usabilità e accessibilità. A chiudere questa prima fase, l’analisi del CTR su base trimestrale, attraverso i dati della Search Console, per valutare il rendimento effettivo delle pagine in funzione dell’interesse generato.

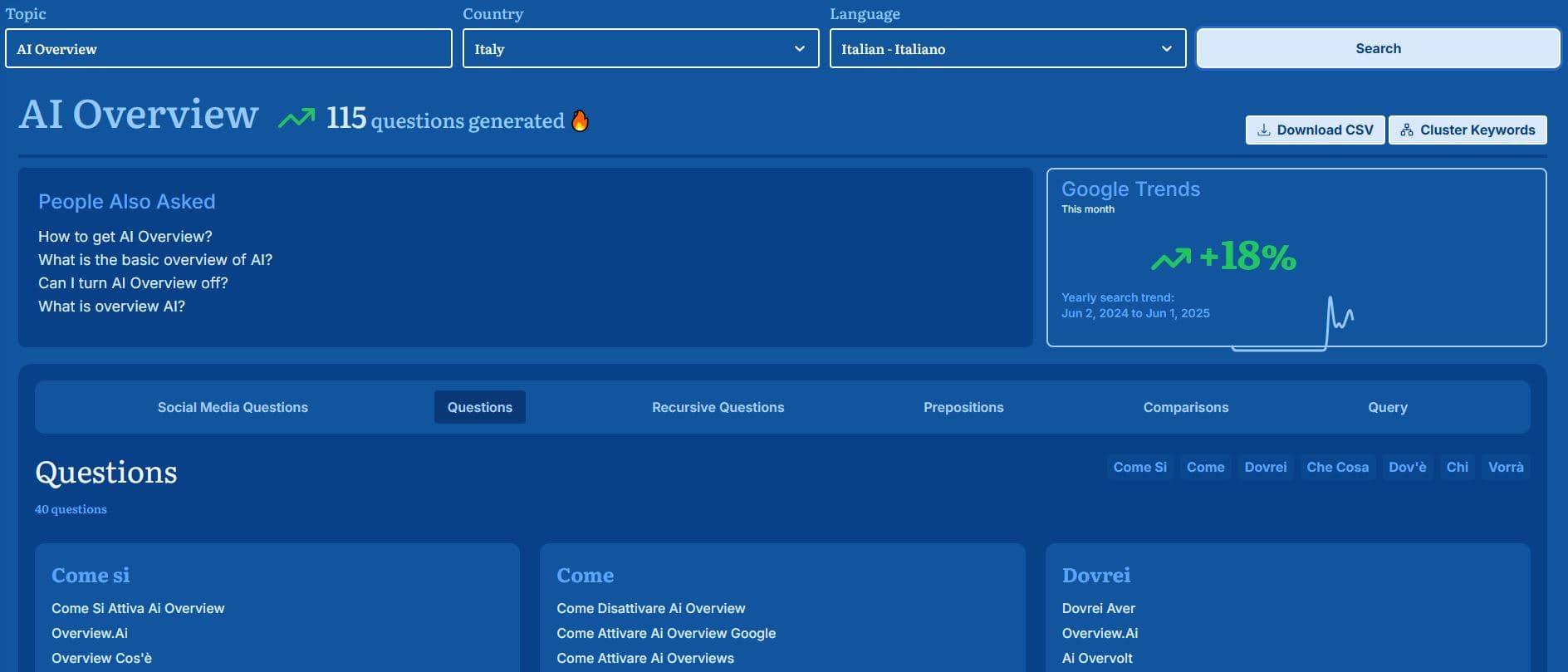

Accanto a questo schema si colloca l’area più colpita dal cambiamento: la pianificazione editoriale. La classica keyword research non risulta più sufficiente, tanto meno la competitor research condotta secondo logiche pre-AI. L’ottimizzazione deve avvenire in funzione del “servizio di ricerca”, in un contesto sempre più dislocato e frammentato, dove l’utente non utilizza più unicamente Google per cercare, ma lo integra o sostituisce con strumenti come ChatGPT, social media e ricerche vocali o visuali.

SEO o S.E.O.? ironia e realtà dietro una sigla in mutazione

Margherita ha evidenziato come il proliferare di sigle e acronimi che cercano di riformulare o estendere il concetto stesso di SEO (da IEO a TEO, passando per MEO e simili) rischi di offuscare il nucleo della disciplina. Il punto non è rinnovare l’acronimo, ma aggiornare il concetto stesso di ottimizzazione: oggi significa operare una vera e propria “search everywhere optimization”, che consideri tutte le modalità e i canali in cui può avvenire una ricerca. Il passaggio chiave è la multimodalità, intesa non come semplice multicanalità, ma come capacità degli strumenti di ricerca di comprendere ed elaborare stimoli differenti (immagini, voce, testo) nella formulazione delle query.

Esemplare, in questo senso, il riferimento a Google Lens: inquadrare un oggetto, accompagnarlo con un input vocale (“li voglio così ma più chiari”) e ottenere una risposta coerente rappresenta un cambio radicale nelle dinamiche di interrogazione. L’interazione dell’utente con la ricerca si arricchisce e si complica, diventando al tempo stesso meno misurabile nei percorsi tradizionali.

Nel delineare questo nuovo scenario, Margherita ha richiamato la figura simbolica della “signora Maria”, che rappresenta l’utente medio: una figura che sempre più spesso non inizia più la sua ricerca su Google, ma parte da TikTok, YouTube, Instagram o persino ChatGPT. Google interviene solo in fase di “ricerca confermativa”, ovvero quando si desidera un riscontro, una verifica o un approfondimento finale.

Questo comportamento riflette una disintermediazione crescente, in cui il motore di ricerca tradizionale non è più il punto di partenza unico o principale. Di conseguenza, le strategie SEO devono evolvere per anticipare e intercettare le ricerche laddove esse realmente nascono.

A conferma dell’efficacia di una SEO concepita come ecosistema multicanale, Margherita ha portato l’esempio concreto del suo cliente Tessiland, un rivenditore di filati. Interrogando ChatGPT su quali fossero i siti più autorevoli per il mondo del crochet e del lavoro a maglia, il primo suggerimento è stato proprio il sito del cliente. Ciò è stato possibile grazie a una strategia coerente che integra video tutorial su Facebook, YouTube, TikTok e Instagram, contenuti gestiti da un team interno ed esterno e una community attiva su Facebook. L’attività editoriale distribuita in più spazi ha costruito un’autorità percepita che si riflette nella visibilità anche in ambiti AI-based.

Tracciamento, referral e l’incognita della provenienza reale degli utenti

Un tema particolarmente critico è quello del tracciamento dei referral. Margherita ha sollevato il problema dell’assenza di link nei suggerimenti AI, a partire da un’esperienza personale: l’acquisto di una spazzola elettrica suggerita da ChatGPT, ma senza alcun collegamento cliccabile. Il problema evidente è la totale opacità nella filiera della conversione: se non c’è link, non c’è referral tracciabile, e quindi non si sa da dove arrivi realmente la vendita.

In alcuni casi, si iniziano a osservare i primi segnali di conversione attribuibile a ChatGPT — centinaia di euro in alcuni e-commerce — ma la casistica è ancora limitata e non consente pattern sicuri. La possibilità che l’utente riceva un nome da ChatGPT e poi lo digiti su Google senza passare da un link diretto rende difficilissima l’attribuzione.

OpenAI contro Google: una concorrenza più sostanziale di quanto sembri

Chiudendo il ragionamento, Margherita ha evidenziato come OpenAI — seppur ancora numericamente inferiore rispetto a Google — stia crescendo come polo di attrazione per le ricerche, in particolare per l’utenza più giovane o per quella che cerca risposte rapide, sintetiche, senza la mediazione dei link. Google ha già perso dal 2 al 3% di share, una cifra apparentemente contenuta ma rilevante in un contesto dominato da numeri su scala globale. L’espansione di strumenti AI-based come ChatGPT, con le sue risposte contestualizzate e prive di interruzioni pubblicitarie, rappresenta un elemento di discontinuità strategica con implicazioni dirette su modelli di monetizzazione, tracking e posizionamento.

SEO e AI generativa: il nuovo ruolo delle menzioni e la ridefinizione del ranking

La progressiva affermazione dei motori di ricerca assistiti da AI, come Google con SGE (Search Generative Experience), Perplexity, ChatGPT e Claude, sta ridefinendo in modo radicale l’equilibrio tra segnali di ranking, spingendo i professionisti SEO a rivedere approcci, metriche e strumenti. Questo cambiamento comporta un rinnovato interesse per le menzioni online, che vanno ora considerate non più come segnali indiretti di autorevolezza, ma come fattori primari, spesso più influenti dei tradizionali backlink.

Nonostante la crescente concorrenza e la disintermediazione dell’accesso all’informazione da parte delle AI assistant, Google mantiene una posizione dominante sul mercato. L’analogia con Microsoft negli anni successivi al ritorno di Steve Jobs in Apple è emblematica: pur avendo perso quote di visibilità, il colosso resta strutturalmente centrale, ma deve adattare il proprio modello di business, anche in ottica di monetizzazione dei risultati AI.

L’esempio riportato di un suggerimento AI legato a una spazzola per capelli, diventata successivamente un best seller su Amazon, dimostra come le AI assistant stiano influenzando direttamente le scelte di acquisto. La citazione non è più un segnale debole, bensì un nodo centrale del nuovo funnel di conversione.

Le AI non operano più soltanto in base a dati strutturati come i backlink. Le entità digitali acquistano rilevanza in funzione dei segnali sociali che le circondano: menzioni su portali, citazioni nei titoli, recensioni, casi studio, contenuti editoriali, discussioni pubbliche. L’emergere dell’associazionismo semantico tra entità, così come la varietà delle fonti che le nominano, produce un impatto diretto sulla visibilità nei risultati AI, oltre che nella SERP classica.

Le chat AI si basano su modelli che ricostruiscono la rilevanza e l’autorevolezza di un sito sulla base della quantità e qualità di ciò che si dice in rete, non più sulla struttura del link graph. Se un brand è frequentemente citato su Reddit, nei titoli degli articoli o nei commenti pubblici, è molto probabile che emerga nei risultati sintetici degli assistenti, persino in assenza di link attivi.

La progressiva centralità delle menzioni nel posizionamento AI e organico

Le menzioni sono divenute uno dei segnali dominanti nel nuovo ecosistema del ranking. Non solo Google sta integrando con sempre più evidenza fonti come Reddit, Quora e altre piattaforme conversazionali pubbliche, ma le stesse agenzie SEO stanno strutturando offerte commerciali basate sul semplice “mentioning”, ovvero la citazione a pagamento del nome del brand o del sito all’interno di articoli editoriali, anche senza collegamento ipertestuale.

È in fase di consolidamento un’economia parallela rispetto alla link building classica: la vendita di menzioni su portali, giornali e blog, che si rivelano capaci di incidere significativamente sul posizionamento. Le correlazioni tra le menzioni nei titoli degli articoli e il posizionamento su Google News e nei risultati AI sono già oggi osservabili empiricamente.

Il rischio spam e l’apertura del vaso di Pandora

Se in passato erano le “link factory” a dominare la scena del black hat SEO, oggi il rischio è che emergano “mention factory”, cioè reti di siti a basso costo che producono grandi quantità di menzioni per conto terzi. Questo approccio, almeno finché non verranno introdotti algoritmi in grado di valutare la coerenza semantica della fonte e la pertinenza tematica della menzione, risulterà difficilmente arginabile.

Il fatto che Google non penalizzi le menzioni e che esse non richiedano un collegamento ipertestuale diretto, le rende strumenti perfetti per generare massa critica a basso costo, almeno temporaneamente. In futuro potrebbe però essere introdotta una forma di penalizzazione basata sulla non coerenza tematica della fonte rispetto al soggetto menzionato.

I backlink non spariscono, ma retrocedono nella gerarchia dei segnali

Il paradigma si è invertito. Se una volta i backlink producevano un effetto diretto e le menzioni un effetto indiretto, ora sono le menzioni a generare visibilità diretta, mentre i backlink contribuiscono in modo secondario, aiutando le fonti autorevoli a posizionarsi e quindi a entrare nei radar delle AI. Il valore del link resta, ma ha cambiato funzione: serve a rafforzare il trust della fonte, non direttamente la pagina linkata.

Questa trasformazione impone un ripensamento delle strategie di link building, che dovranno essere affiancate o sostituite da pratiche più orientate alla costruzione dell’awareness tramite contenuti editoriali citazionali, citazioni nei forum pubblici, articoli branded e recensioni.

Overview AI e calo dei clic: nuovi filtri per nuove metriche

Un’altra variabile che si somma è la progressiva perdita di click, anche per siti ben posizionati, causata dalla maggiore autosufficienza degli snippet AI overview, che spesso rispondono direttamente nella SERP. Per reagire a questo fenomeno, strumenti come Sistrix hanno introdotto il filtro AI overview, che consente di isolare le keyword che mostrano esclusivamente risultati generativi.

Questa funzione offre un vantaggio competitivo immediato: permette di orientare le attività di keyword research verso termini in cui è ancora attivo un comportamento di click-through verso i siti, ottimizzando così le attività editoriali e SEO.

Analisi semantica, modelli LDA e strumenti di nuova generazione

Con l’aumento dell’importanza semantica e dell’associazionismo tra concetti, si rafforza anche l’interesse per tecniche di analisi del contenuto basate su modelli LDA (Latent Dirichlet Allocation), che consentono di individuare i topic latenti in un corpus testuale. Tali modelli, un tempo disponibili solo tramite strumenti di ricerca avanzati, sono oggi accessibili anche via ChatGPT o Claude, con prompt specifici.

Strumenti come il Word Tree di Jason Davies, oggi integrato in SEOZoom, rappresentano un’altra risorsa utile per mappare la frequenza con cui certi termini aprono o chiudono le frasi. Questo tipo di visualizzazione facilita lo studio della struttura retorica di un testo e supporta l’analisi delle co-occorrenze tematiche, utile per migliorare la coesione semantica delle pagine.

Anche in assenza di programmazione avanzata, oggi è possibile ottenere cluster di termini, associazioni lessicali, e suggerimenti sui sotto-temi da trattare tramite prompt ben calibrati alle AI generative, che restituiscono in pochi secondi strutture simili a quelle dei modelli LDA o TF-IDF.

La transizione verso una SEO meno link-centrica e più relazionale

L’orizzonte che si profila richiede una SEO meno focalizzata su aspetti strutturali e più orientata alla relazione tra entità, alla costruzione della reputazione e alla capacità di diffondere la propria presenza all’interno dell’ecosistema informativo. Le menzioni si rivelano oggi il ponte tra branding e search, tra social proof e ranking, tra editoria e intelligenza artificiale.

A breve termine, chi saprà investire in strategie di visibilità non link-based otterrà risultati significativi, sfruttando anche i margini di costo ancora favorevoli dei servizi di mentioning. Nel medio periodo, sarà inevitabile che Google applichi un filtro qualitativo anche alle menzioni, riconoscendo pattern sospetti e premiando quelle provenienti da fonti coerenti e autorevoli. Nel frattempo, la finestra di opportunità per sfruttare il nuovo paradigma è già aperta.

Il ruolo trasformativo dell’IA nell’audit SEO e i limiti attuali

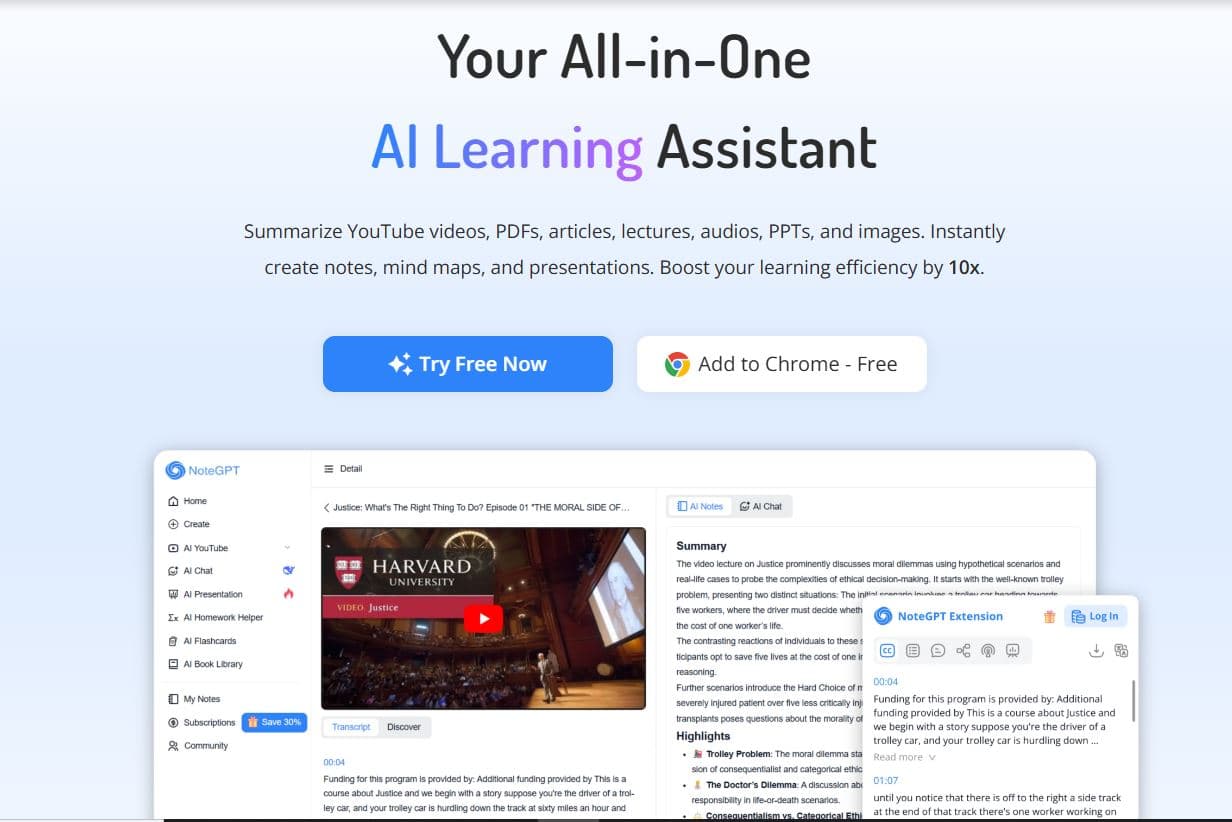

La possibilità di integrare strumenti di intelligenza artificiale nei processi SEO ha aperto scenari di lavoro completamente nuovi, soprattutto per quanto riguarda le attività di auditing e produzione documentale. Uno degli aspetti più rivoluzionari è rappresentato dalla riduzione drastica dei tempi necessari per ottenere risultati di alto livello. Un’analisi match che avrebbe richiesto una settimana di lavoro può ora essere portata a termine in tre o quattro ore, pur mantenendo un alto grado di accuratezza. L’audit in itinere, che un tempo era uno strumento limitato per le revisioni settimanali, acquisisce ora un valore molto più profondo, con un contenuto informativo di gran lunga superiore rispetto al passato, mantenendo però invariati i tempi di produzione.

Uno dei parametri fondamentali da considerare in questo tipo di analisi è il numero di topic (numtopics) estratti nel topic modeling. In alcuni casi, gli strumenti IA possono fallire nel generare i sotto-argomenti rilevanti, ma insistendo e affinando le richieste, è possibile ottenere insight utili. L’utilizzo dell’intelligenza generativa in ambito SEO si dimostra quindi molto efficace per l’analisi dei contenuti in itinere e per individuare elementi di ottimizzazione, mentre resta ancora debole sul piano tecnico, dove le valutazioni offerte risultano elementari e poco affidabili per chi possiede una visione SEO avanzata.

L’IA si rivela però estremamente performante nel trattamento dei dati quantitativi. Nella lettura di tabelle, nel confronto di metriche e nella rilevazione di variazioni significative tra dati statistici e risultati reali, le capacità computazionali si esprimono al massimo. Una delle sperimentazioni in corso più promettenti è l’analisi delle variazioni di posizionamento e dei click combinata con le metriche di rendimento. L’intelligenza artificiale consente di generare ipotesi di test che un tempo sarebbero state difficilmente individuabili, suggerendo modifiche come l’aggiunta di FAQ, la variazione degli snippet di titolo o la modifica dei link interni.

Nonostante questi progressi, resta problematica la capacità di interpretare aspetti tecnici critici come la copertura dell’indice di Google. L’IA fatica a comprendere le relazioni dialogiche tra pagine scansionate, indicizzate e non ancora indicizzate, che spesso richiedono una lettura esperta basata sull’esperienza del SEO. Tentativi di ottenere feedback strutturati su queste dinamiche da modelli linguistici avanzati non hanno portato a risultati soddisfacenti. L’interpretazione delle informazioni di copertura resta quindi appannaggio dell’esperienza umana.

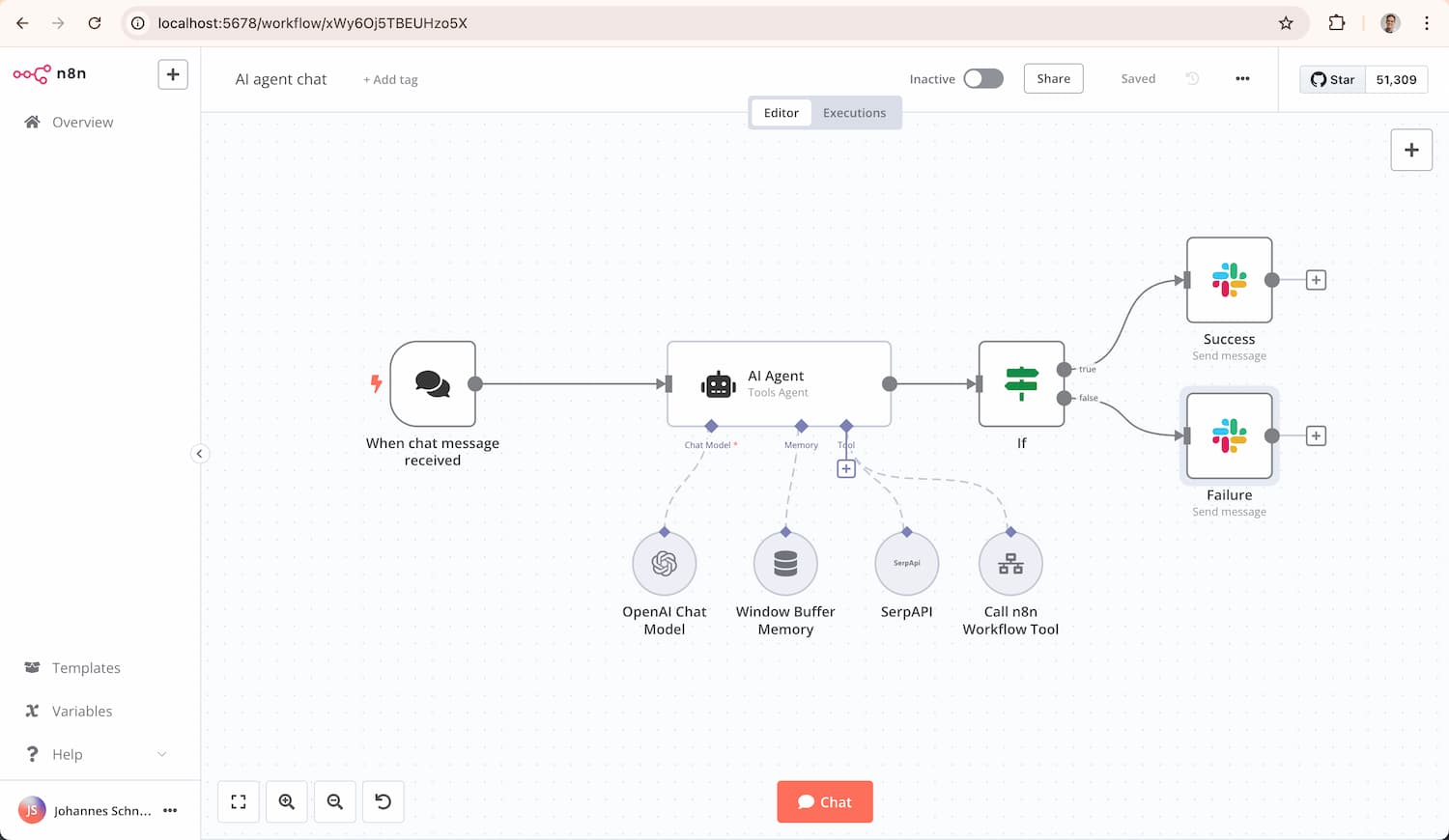

Ecosistemi IA personalizzati e nuove prospettive operative

Un tema di particolare rilevanza è la personalizzazione che ChatGPT e altri LLM (Large Language Model) possono raggiungere nel tempo. Un modello che ha lavorato a lungo con un professionista tende a generare risposte sempre più affinate, modellandosi sui bisogni, sulle preferenze comunicative e sui pattern cognitivi dell’utente. Questo aspetto rende l’interazione simile a quella con un assistente umano, in grado di anticipare richieste e suggerire soluzioni coerenti con lo stile e gli obiettivi dell’interlocutore. La questione dell’effettiva cancellazione della memoria e dei dati pregressi rimane però un punto aperto, poiché alcuni segnali fanno pensare che certi modelli conservino riferimenti anche dopo l’eliminazione apparente delle conversazioni.

Il GPT personalizzato, adattato al modo di lavorare e pensare di un SEO, non restituisce risposte generiche, ma diventa una protesi intellettuale, capace di amplificare le potenzialità dell’utente. L’utilizzo dell’IA in chiave esperta richiede quindi non solo una padronanza degli strumenti, ma anche una profonda simbiosi tra operatore e modello, che si costruisce nel tempo attraverso l’interazione e l’affinamento continuo.

Dal punto di vista operativo, si stanno aprendo nuove linee di sperimentazione, in particolare legate alla rilevanza semantica attribuita ai brand e alle pagine dai modelli linguistici. Le indicazioni che emergono dai suggerimenti di ottimizzazione spesso includono elementi tecnici come i dati strutturati, anche se l’effettiva incidenza di questi interventi sul ranking resta da dimostrare in modo empirico. Una delle prospettive più interessanti è quella di riuscire a ottenere da questi strumenti inferenze affidabili su anomalie nella copertura indice, come l’improvvisa indicizzazione di pagine bloccate da robots.txt, fenomeno difficile da spiegare anche per gli esperti.

Questa ricerca sull’inferenza applicata alla copertura si affianca alle analisi match tra dati statistici e dati reali, all’uso sistematico del topic modeling per la creazione e l’ottimizzazione dei contenuti, e a una riflessione più profonda su meccanismi semantici che potrebbero spiegare posizionamenti sorprendenti di siti non particolarmente autorevoli, spesso riconducibili a fenomeni fortuiti di prossimità semantica e menzioni involontarie.

Leave a Reply